Go调度器的艺术:高并发背后的协作哲学与工程智慧

本文最后更新于 2025-07-25,文章内容可能已经过时。

导语:当Go宣称“轻松支持百万级并发”时,其核心秘密在于革命性的调度器设计。本文将穿透Goroutine的轻量表象,揭示调度器如何在效率与公平间取得精妙平衡,以及如何规避千万级并发下的致命陷阱。

一、GMP模型:三级协作的精密机械

角色分工的本质

Goroutine (G):非传统线程,而是携带栈指针、程序计数器的任务单元(初始栈仅2KB,可动态扩容)

Machine (M):绑定内核线程的真实计算引擎,负责执行机器指令

Processor (P):调度器的中枢协调器,持有本地G队列(避免全局锁竞争)

动态绑定的智慧

P的数量默认为CPU核心数,构成并行度天花板

M的数量由运行时按需创建,当M阻塞时(如系统调用),调度器会解绑P并创建新M

关键优势:I/O阻塞不会耗尽线程资源,P队列中的G可被其他M继续执行

二、协作式调度的精妙平衡

主动让出的艺术

显式切换:

runtime.Gosched()将当前G放回队列,触发调度隐式切换点:

通道阻塞(发送/接收等待)

网络I/O触发netpoller异步回调

time.Sleep引发的定时器挂起垃圾回收的STW阶段

抢占式进化的困境与突破

Go 1.2前痛点:纯协作式调度导致CPU密集型Goroutine饿死其他任务

解决方案:

Go 1.2:函数调用时插入栈扩张检查,实现协作式抢占

Go 1.14:基于信号的异步抢占(每10ms发送SIGURG信号),彻底解决长循环阻塞

三、千万级并发的生存法则

资源泄漏的幽灵

典型场景:未关闭的通道导致接收Goroutine永久阻塞;

sync.WaitGroup误用引发死锁诊断工具链:

bash

# 查看Goroutine阻塞堆栈 go tool pprof http://localhost:6060/debug/pprof/goroutine?debug=1 # 实时监控调度器状态 GODEBUG=schedtrace=1000 ./program

负载均衡的实践策略

流量洪峰的防御工事

有界队列:通道设置合理缓冲区,避免生产者压垮消费者

熔断机制:当任务处理超时率>5%,自动缩减并发度

优雅降级:高负载时暂停非核心业务Goroutine

四、调度器的黑暗面:当理想遭遇现实

缓存局部性陷阱

问题:Goroutine频繁迁移导致CPU缓存命中率下降

实测:当G在P间迁移次数>1000次/秒,性能下降可达30%

优化:通过

runtime.LockOSThread()绑定关键G到指定线程

虚假的并行性

案例:1000个Goroutine竞争同一互斥锁,实际退化为串行执行

洞察:

go test -bench . -cpuprofile分析真实CPU利用率

五、未来演进:调度器的未竟之战

NUMA架构适配

现状:Go调度器无视CPU插槽拓扑,跨NUMA节点调度引发内存延迟

提案:为P增加NUMA亲和性标签,实现本地内存优先分配

异构计算支持

挑战:GPU/DPU等设备无法直接纳入GMP模型

探索:通过

runtime/cgo桥接外部计算单元,建立异构任务队列

工程师的抉择时刻:

当你面临10万/秒的请求洪峰,应选择:

启动10万Goroutine(轻量但高切换开销)

采用1000 Goroutine+事件循环(复杂但高缓存命中)

答案取决于任务类型:短任务选前者,长连接选后者

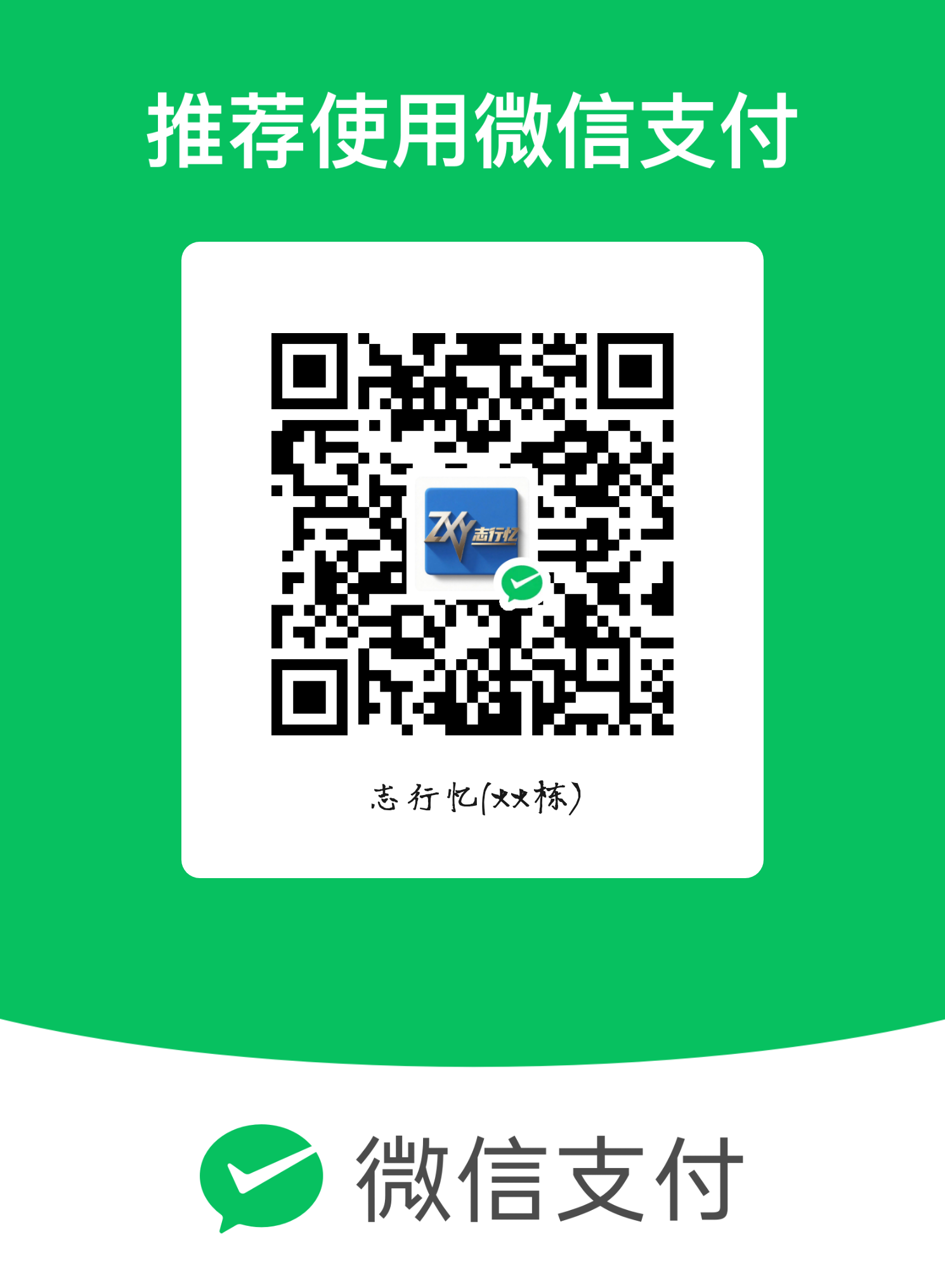

- 感谢你赐予我前进的力量